在深度學習中,神經網路的「模型層數」指的是模型的深度,也就是由多少層的神經元堆疊而成。設定模型層數沒有一個絕對的標準答案,它需要根據你的資料複雜度和運算資源來權衡。

- 模型的深度與廣度

- 層數(深度):指的是從輸入層到輸出層之間,中間隱藏層的數量。層數越多,模型越深,能學習到的特徵也越抽象、越複雜。

- 神經元數量(廣度):指的是每一層中神經元的數量。神經元越多,該層能處理的資訊量越大。

這兩者通常需要搭配使用。例如,對於一個複雜的圖像識別任務,你可能需要一個更深、更寬的網路來提取從邊緣、形狀到物體本身的複雜特徵。

- 選擇層數的考量

(1) 越深越好嗎?

不一定。雖然更深的模型理論上能學習更複雜的模式,但這會帶來幾個問題:

- 運算量大:訓練時間會大幅增加,需要更強大的硬體。

- 容易過度擬合 (Overfitting):模型可能會過度學習訓練資料中的雜訊和特徵,導致在新的資料上表現不佳。

- 梯度消失/爆炸:在非常深的網路中,訓練過程可能會遇到梯度值變得極小或極大的問題,讓模型無法有效學習。

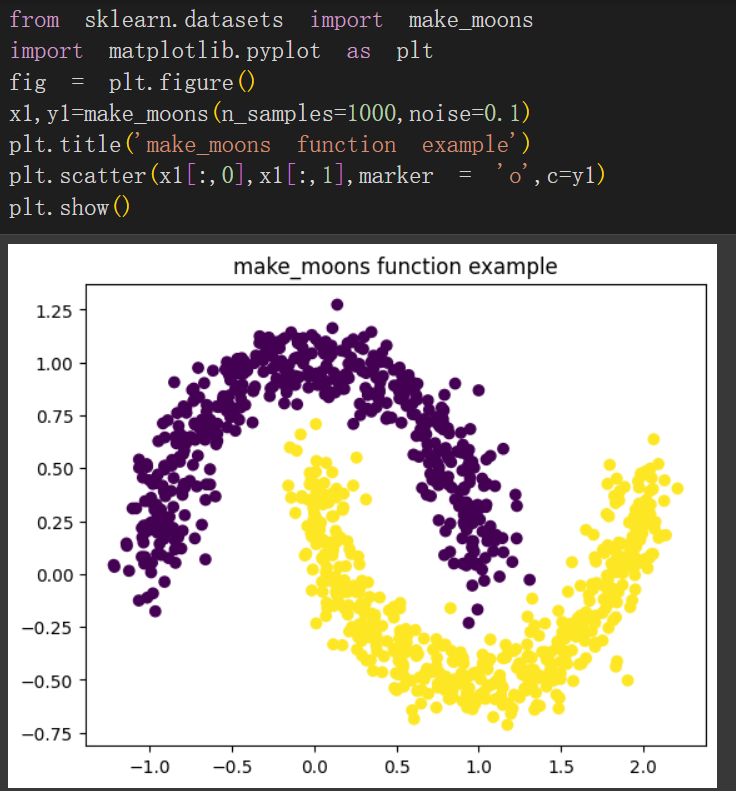

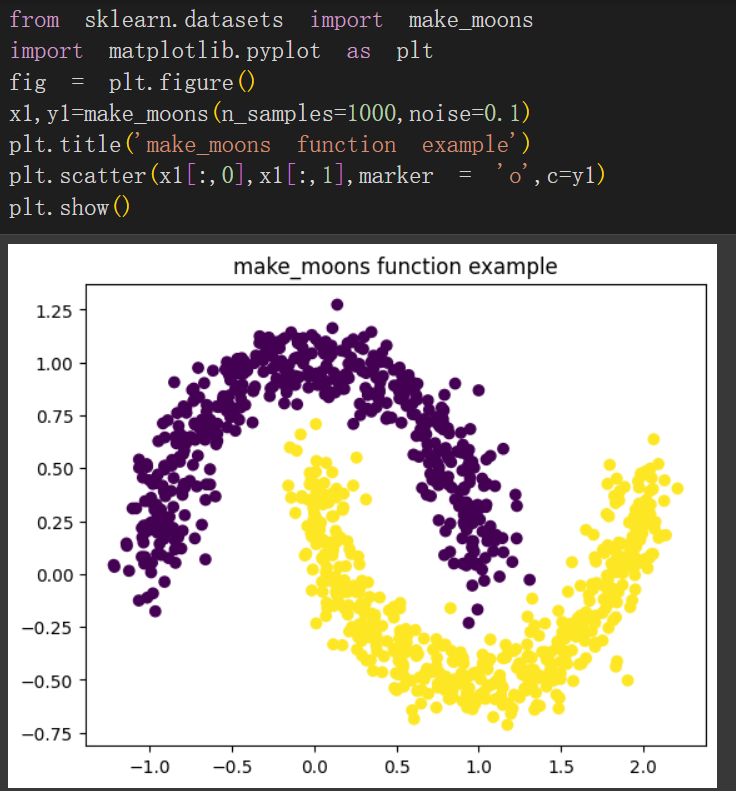

(2) 考慮資料的複雜度

- 簡單任務:如果你的資料特徵很明確,例如二元分類問題或簡單的線性回歸,一個淺層的網路(1~2 個隱藏層)通常就足夠了。

- 複雜任務:對於圖像識別、語音辨識等需要從原始資料中提取複雜特徵的任務,你可能需要使用多個隱藏層。

- 常見的設定方法

由淺入深:

這是一個很實用的策略。一開始,先從一個簡單、淺層的模型開始,例如只用一個或兩個隱藏層,並觀察它的表現。

- 如果模型的訓練準確率很低(欠擬合),這表示模型的能力不足以學習資料的模式,這時可以增加層數或每層的神經元數量。

- 如果模型在訓練集表現很好,但在驗證集上表現很差(過度擬合),這表示模型太複雜了。你可以減少層數、減少神經元數量,或使用像是 Dropout 和 Early Stopping 等正規化技巧來改善。

參考經典模型:

許多領域都有經過驗證的經典模型架構。例如,在圖像處理領域,你可以參考 VGG、ResNet 或 Inception 等模型。這些模型已經證明在相關任務上表現良好,你可以將它們作為起點,再根據自己的資料進行調整。

使用自動化工具:

近年來,一些自動化機器學習 (AutoML) 工具可以自動搜尋並找到最佳的模型架構,這能節省你手動嘗試的時間。